1. 릿지 회귀

-> 학습 알고리즘을 데이터에 맞추면서 모델의 가중치가 가능한 작게 유지하려고 함

-> 규제항은 훈련하는 동안에만 비용 함수에 추가되고, 모델의 성능은 규제가 없는 성능 지표로 평가함

-> a는 모델을 얼마나 많이 규제할지 조절하는데, 0이면 선형회귀와 같아짐

2. 라쏘 회귀

-> 덜 중요한 특성의 가중치를 제거하려고 하는 경향 (가중치를 0으로 만듬)

-> 자동으로 특성을 선택하여 sparse model을 만듬 (0이 아닌 특성의 가중치가 적음)

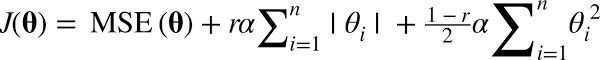

3. 엘라스틱넷 (라쏘 + 릿지 = 쏘릿)

-> r을 통해 라쏘와 릿지 회귀의 혼합 비율을 조절함

1) 일반적으로 규제가 약간있는 것이 대부분의 경우에 좋아 평범한 선형 회귀는 피하는 것이 좋음

2) 기본적으로? -> 릿지

3) 특성이 몇 개뿐이라고 의심될 때는 -> 라쏘 or 엘라스틱넷

4) 특성 수가 훈련 샘플 수보다 많거나 특성 몇 개가 강하게 연관되어 있을 때는 라쏘 < 엘라스틱넷

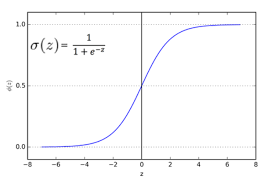

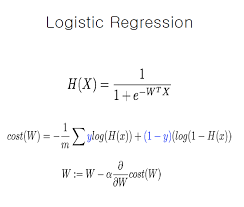

4. 로지스틱 회귀 (이거 분류라고~)

-> 선형회귀처럼 결과를 출력하지 않고 로지스틱을 출력함

-> 확률값에 의해 분류 클래스 예측

5. 소프트맥스 회귀

-> 소프트맥스 함수를 통해 각 클래스별 확률값 계산

-> 다중 클래스 분류를 지원하도록 일반화되어 다항 로지스틱 회귀라고도 함

-> 크로스 엔트로피 함수를 Loss function으로 이용

-> 타깃 클래스에 대해 낮은 확률을 예측하는 모델을 억제함

-> 딥러닝 모델에서 소프트맥스 함수 + 크로스엔트로피 함수 => 오차역전파시 loss를 그대로 전달할 수 있음 찰떡궁합임

'AI_basic > ML' 카테고리의 다른 글

| [ML] SVM (0) | 2022.08.01 |

|---|---|

| [ML] 지도학습/회귀 회귀 평가 지표 Part.2 (1) | 2021.09.24 |

| [ML] 지도학습/회귀 회귀 평가 지표 Part.1 (1) | 2021.09.24 |

| [ML] 비지도학습 / 군집화 / K-means (0) | 2021.07.30 |

| [ML] 데이터 전처리 - SMOTE 오버 샘플링 (0) | 2021.07.24 |